Mit der Veröffentlichung des Chatbots ChatGPT3 von OpenAI im November 2022 ist, was als „künstliche Intelligenz“ bezeichnet wird, wiederholt in den gesellschaftlichen Vordergrund gerückt und zu einem der meistdiskutierten Themen geworden. Knapp 11 Monate später vergleichen manche es mit dem „Iphone Moment“ als Steve Jobs 2007 das erste IPhone auf der MacWorld präsentierte. Zeitgleich wurden auch einige kritische Stimmen laut, welche auf die Gefahren dieser neuen Technologie aufmerksam machen möchten.

Nach knapp zwei Monaten stieg die Userzahl von ChatGPT bereits auf über 100 Millionen Nutzer – eine durchaus beachtliche Entwicklung im Vergleich mit dem Wachstum anderer populärer Anwendungen. Laut Greg Brockman, einer der Gründer von OpenAI, geht der Erfolg vor allem darauf zurück, dass „jedes Business bereits ein Sprachbusiness ist“ und die Nutzung dieser sprachbasierten Anwendung dem Nutzer keine neuen Fähigkeiten abverlangt.

Nun ist es nicht der Mensch, der die Nutzung erlernt, sondern der Computer erlernt menschliche Sprache und ermöglicht so eine intuitive Handhabung in Form eines Dialogs. Durch einen sogenannten Prompt in Form von Text gibt der User seine Instruktionen an das Sprachmodell weiter und erhält eine Antwort mit Bezug auf die initiale Anfrage.

Dabei kann ChatGPT Zusammenfassungen von Texten, ausführbaren Codes in verschiedenen Programmiersprachen, sowie Gedichte im Stil von Shakespeare schreiben. Zudem können Ausgaben durch weitere Instruktionen feinjustiert werden, da ChatGPT sich auf eigene sowie weitere Aussagen des Users beziehen kann. Der Computer wird somit zu einer Art „Sinnmaschine“ und tritt in menschenartige Interaktion mit uns.

Doch kann bei aller Euphorie über diese neue Technologie von Fortschritt gesprochen werden? Einige Aussagen führender Persönlichkeiten der Unternehmen offenbaren, wie hier über Fortschritt gedacht wird. Es ist eine Vorstellung, welche sich durch ein stark technisch-reduktionistisches Bild auszeichnet. Hört man beispielsweise Sam Altman, dem CEO von OpenAI zu, so schließt man sich vielleicht gern seinen vermeintlich philanthropischen Absichten an. Denn wer möchte nicht, dass Bildung und individuelles Lernen für alle Menschen dieser Welt möglich ist oder die Mysterien bisher nicht heilbarer Krankheiten gelöst werden können?

Diese Argumente erinnern jedoch sehr stark an die Doktrin des „Solutionism“, welche bereits von Evgeny Morozov ausführlich in seinem Buch „To Save Everything Click Here“ kritisiert wurde. Sie bezeichnet die Ideologie, dass wir jedes Problem, mit dem wir konfrontiert sind, mit der richtigen App, dem richtigen Algorithmus oder dem richtigen Technologiebaustein

lösen werden können. Diesen Glauben an Fortschritt durch Technologie kann man auch als Illusion des Fortschritts bezeichnen

Denn wie soll eine solche Technologie zu einem Gemeinwohl führen, wenn die Teilhabe an der Entwicklung solcher Systeme weiterhin der Öffentlichkeit verschlossen und die getroffenen Entscheidungen im Entwicklungsprozess, aufgrund von proprietären Interessen intransparent verbleiben?

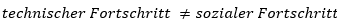

Wird von Tech-Unternehmen über Fortschritt gesprochen, werden vordergründig noble Ziele genannt, doch zumeist verenden diese in ökonomischen Interessen und reduzieren sich auf Automatisierung menschlicher physischer Tätigkeiten. Durch künstliche Intelligenz könnte sich dieser Prozess in Zukunft auch auf geistige Tätigkeiten ausweiten. Doch Fortschritt lässt sich nicht auf reine betriebswirtschaftliche Prozessoptimierung reduzieren. Ein integraler Bestandteil insbesondere menschlichen Fortschritts ist der soziale Aspekt. Dabei gilt es zu unterscheiden:

Diese Ungleichung wird zunehmend als Gleichheit verstanden mit zumeist verheerenden Konsequenzen für jegliche Art von sozialem Fortschritt. Denn für wahrhaften Fortschritt müssen die Charakteristika der Probleme genauso in den Fokus gerückt werden, wie die Problemlösungen selbst. Ein rein technokratischer Ansatz reduziert die Vielschichtigkeit unseres menschlichen Daseins. Bei neuen Technologien wie z.B. Large Language Models, die oft mit dem leicht überhöhten Begriff der Intelligenz bezeichnet werden, muss also danach gefragt werden wie Probleme überhaupt definiert und erkannt werden. Wo liegen also die Grenzen solcher mathematischen Berechnungen und statistischer Vorhersagen?

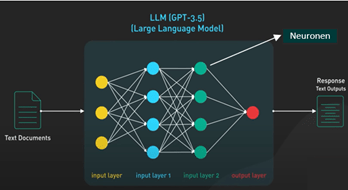

Große Sprachmodelle (Large Language Models) wie GPT sind darauf trainiert, menschenähnliche Texte zu generieren, indem sie Muster, Syntax, Semantik und Zusammenhänge in den Daten, mit denen sie trainiert wurden, verstehen. Durch das Training mit einer gigantischen Menge an Texten aus Büchern und dem Internet, werden die Wahrscheinlichkeiten und Beziehungen innerhalb der Texte als Parameter in das Modell eingespeist. Man kann sich diese Parameter wie kleine Stellschrauben vorstellen, welche das Modell feinjustieren, um akkurate Antworten zu generieren. Dabei stellen die Parameter Wahrscheinlichkeiten dar und bestimmen welche(s) Wort, Wortgruppe oder Textphrase auf ein gegebenes Set von Wörtern folgt.

Diese Parameter werden auch als Neuronen bezeichnet und bilden in ihrer Gesamtheit ein neuronales Netz, welches sich wiederum aus verschiedenen Schichten zusammensetzt.

Insgesamt besitzt das zugrunde-liegende Model von ChatGPT 175 Milliarden solcher Neuronen. Auch wenn es sich hier um eine gigantische Zahl handelt, ist diese noch weit entfernt davon unsere Realität genaustens vorherzusagen.

Denn einer statistischen Annährung menschlicher Sprache durch maschinelles Lernen obliegt eine Grenze, sofern die Antworten auf einer oberflächlichen syntaktischen und semantischen Analyse beruhen. Denn die Aussagen von ChatGPT basieren nicht auf einem wirklichen Verständnis der Anfragen. Auch wenn die Ausgaben verblüffend menschlich klingen, muss man sich im Klaren darüber sein, dass solche Modelle zwar die Struktur der Sprache und gewisse in den Trainingsdaten vorhandene Muster imitieren können, aber nicht die zugrundeliegenden menschlichen Intentionen, Gefühle oder subtilen sozialen Nuancen, welche in menschlicher Kommunikation oftmals präsent ist, nachvollziehen.

Darüber hinaus sind die komplexen Muster, die neuronale Netze in ihren Trainingsdaten erkennen, oft schwer nachvollziehbar. Dies kann zu unerwarteten oder fehlerhaften Interpretationen führen, welche auch als Halluzinationen bezeichnet werden. Das bedeutet, dass die Grenzen einer solchen Technologie nicht ausschließlich auf eine mangelnde Rechenleistung zurückzuführen sind, sondern auch darauf, dass wenn kollektive Ereignisse auftreten, emergente Phänomene nicht allein aus den kenntlichen fundamentalen Wechselwirkungen abgeleitet werden können.

Nun kommt hinzu, dass künstliche Intelligenz nicht nur in der Forschung naturwissenschaftlicher Fragestellungen verwendet wird, sondern auch in der Berechnung sozialen Verhaltens, bspw. in Software, die Richter:innen in ihrem Entscheidungsprozess über das Fluchtrisiko von Angeklagten, beraten. Dabei stellt sich die Frage, welche Variablen überhaupt in der Gleichung für eine solche Vorhersage berücksichtigt werden sollen. Hinter verschlossenen Türen der Unternehmen, die solche Technologien bereitstellen, finden somit Normierungsprozesse statt, die darüber entscheiden. Dabei handelt es sich nicht um ein einmaliges Problem: Durch sozialen Wandel verändern sich alle vermeintlichen Messpunkte fortlaufend und stehen in einem neuen Verhältnis zueinander. Somit ist grundsätzlich unklar welche dieser Features überhaupt in der Zielgleichung des Models miteinbezogen werden müssten. In der Anwendung kommt es zusätzlich oft zu einem sogenannten Automatisation Bias, wenn Richter:innen durch mangelnde technische Fachkenntnisse dazu neigen, die getroffenen Entscheidungen und Ausgaben solcher Systeme unreflektiert zu übernehmen. Die zunehmende Intransparenz über Entscheidungen, welche wir algorithmisierten Prozessen überlassen, birgt dabei die Gefahr bisher subjektive Entscheidungsprozesse zu objektivieren und somit als Norm anzusehen. Es findet Blackboxing statt, welches die Kritik solcher Entscheidungen schier unmöglich macht, da die tatsächliche Entscheidung nur von einem sehr kleinen Kreis an Entwickler:innen und Unternehmen dieser Systeme getroffen werden, welche die Intransparenz durch proprietäre Interessen rechtfertigen.

Über die Isolation und Intransparenz hinaus, in welcher der Entwicklungsprozess neuer Anwendungen stattfindet, stellt auch die Vernachlässigung ganzer Bevölkerungsgruppen ein Problem dar. Die Produktionsstätten liegen primär in reichen und strukturstarken Ländern. Somit spiegeln sich auch in Anwendungen wie ChatGPT die kulturellen Normen dieser Länder wider, welche eine hegemoniale Stellung gegenüber Usern aus anderen Kulturkreisen einnehmen. Zwar sind Large Language Models durch ihre Fähigkeit menschliche Sprache zu verstehen für eine größere Anzahl an Personen zugänglich, jedoch zeigt sich eine deutliche Diskrepanz in der Qualität der Ausgaben hinsichtlich in der Entwicklung weniger berücksichtigter Sprachen. Die Modelle funktionieren vor allen Dingen in westlichen Sprachen.

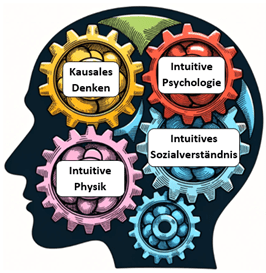

Soziales sowie menschliches Verhalten insgesamt lässt sich also nicht durch ein auf Binarität basierendes Operationssystem reduzieren. Das menschliche Gehirn allein besteht aus Milliarden von Neuronen, die elektrische und chemische Signale senden und empfangen. Obwohl jedes Neuron relativ einfach ist, entstehen aus ihren Interaktionen komplexe Phänomene wie Gedanken, Emotionen und Bewusstsein. Die Zahnräder des gesunden Menschenverstands zeichnen sich dabei durch intuitive Fähigkeiten aus, wie etwa kausales Denken, intuitive Psychologie, intuitive Physik und intuitives Sozialverhalten.

Doch eine solche Sichtweise findet auf Grund von reduktionistisch-ökonomischen Interessen zumeist nur wenig Beachtung. Vielmehr dominiert die Vorstellung, dass der Mensch eventuell durch eine mögliche AGI, einer sogenannten Artificial General Intelligenz, ganzheitlich übertroffen werden kann. Doch durch fortwährend auftretende Halluzinationen in solchen Systemen, sollten Zweifel aufkommen. Das Problem der Halluzinationen ist eine langjährige Begleiterscheinung in der Forschung zu künstlicher Intelligenz basierend auf der aktuellen Struktur, wie diese Systeme konzipiert sind. Dabei tritt neben dieses Phänomen die Problematik der Erklärbarkeit (Explainability), also wie sich die Zusammenhänge in einem neuronalen Netz bilden bzw. ergründen. Auch wenn Altman davon spricht, ChatGPT zukünftig mehr hin zu einem ergründenden System und weg von einer Faktendatenbank zu entwickeln, stellen die genannten Probleme erhebliche Hürden dar. Seine Vorstellung gleicht so eher einer Illusion.

Die Konsequenzen einer solch überhöhten Selbstwahrnehmung über die Machbarkeit dieser Anwendungen, gepaart mit einem Technofeudalismus, kann bereits im Arbeitsmarkt beobachtet werden. Altman ist durchaus bewusst, dass AI viele Jobs abschaffen wird, er behauptet jedoch auch, dass viele neue Jobs geschaffen werden.

Doch wie bereits in der Vergangenheit durch ökonomische Untersuchungen ersichtlich wurde, sind diese neuen Jobs durch einen divergierenden Trend gekennzeichnet. Der Arbeits-markt differenziert sich durch das Voranschreiten der Digitalisierung, mit ihrer Notwendigkeit an immer höher spezialisierten Arbeitskräften, immer weiter aus.

Es wird zunehmend Jobs geben, welche sehr viel höhere Wissensanforderungen an das einzelne Individuum stellen als zuvor. Gleichzeitig stehen diese, Jobs mit abnehmenden Anforderungen, wie beispielsweise Clickworker oder Moderators, die einer erhöhten Prekarität ausgesetzt sind, gegenüber. Dadurch wird Ungleichheit verstärkt. Dieser Prozess wird in der Ökonomie auch allgemein als Arbeitsmarkpolarisation bezeichnet.

Daher kann, angesichts der Weltfremdheit oder sogar Überheblichkeit mit der Sam Altman in seiner PR-Kampagne wiederholt von AI schwärmt, von Hybris gesprochen werden. Denn ganzheitlicher Fortschritt, im technisch, wie sozialen Sinne, bleibt weiterhin eine Illusion, wenn ein zunehmender Teil der Bevölkerung an diesen neuen Entwicklungen nicht teilhat. Ein solcher Fortschritt lässt sich nur aus einem vielschichtigen und demokratisch partizipativen Diskurs heraus entwickeln, nicht aber mit privatwirtschaftlichen Profitinteressen.

Noel Eleuterio