Algorithmen scheinen neutral und objektiv, denn sie folgen klaren Regeln und entscheiden ohne sich emotional leiten zu lassen. Ist das wirklich so, oder kann man darauf vertrauen, dass sie aufgrund dieser Eigenschaften faire Bewertungen auch im Bereich komplexer Entscheidungsfindung vornehmen können, die in vielen gesellschaftlichen Bereichen zunehmend gefragt sind? Ein Beispiel hierfür ist die algorithmische Risikobewertungssoftware COMPAS (Correctional Offender Management Profiling for Alternative Sanctions), welche im amerikanischen Justizsystem hauptsächlich dafür eingesetzt wird, um das Rückfallrisiko von Straftäter*innen in Bezug auf Straf- und Gewaltstraftaten zu bewerten. Das Ergebnis dieser Bewertungen beeinflusst wiederum die Entscheidungen von Richter*innen bei der Strafzumessung, bei Anträgen auf vorzeitige Haftentlassung oder auch ob ein*e Angeklagte*r während der Wartezeit auf den Prozess im Gefängnis verbleiben oder freigelassen werden sollte.

Equivant/Northpointe, die Betreiberfirma von COMPAS, hält den Algorithmus weitestgehend unter Verschluss, lediglich die allgemeine Struktur wurde offengelegt. COMPAS unterscheidet zwischen zwei Modellen, eines um allgemeine Straftaten und eines um Gewaltstraftaten zu betrachten. Beide Modelle folgen den drei gleichen Aspekten:

- Inputvariablen – Allgemeine Straftaten: z.B. Alter, kriminelle Vorgeschichte, kriminelles Umfeld, Drogenmissbrauch und Anzeichen für Jugendkriminalität. Durch einen Fragebogen werden ca. 70 Faktoren berücksichtigt. Gewaltstraftaten: z.B. vorherige Gewalttaten, Disziplinarprobleme, berufliche und bildungsbezogene Probleme, Alter bei aktueller und bei erster Verhaftung.

- Innere Struktur der Modelle – Beide Modelle nutzen eine lineare Struktur, die auf der gewichteten Summe der Faktoren basiert. Die Anwendung der Modelle dauert zwischen 10 und 60 Minuten pro Fall. Die genauen Details, insbesondere die Gewichtung der jeweiligen Faktoren, ist nicht öffentlich zugänglich.

- Output-Variablen: Die Risikoprognose wird in Dezilen von 1 bis 10 dargestellt. Ein Wert von 1-4 zeigt ein niedriges Risiko, 5-7 ein mittleres Risiko und 8-10 ein hohes Risiko an, innerhalb einer bestimmten Zeitspanne erneut straffällig zu werden (z.B. zwei Jahre nach Entlassung aus dem Gefängnis).

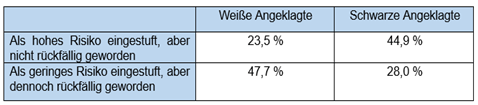

Auf den ersten Blick mag der Einsatz von COMPAS unproblematisch erscheinen. Doch ein Bericht von ProPublica (2016) zeigte vor einigen Jahren, dass Schwarze Angeklagte fast doppelt so oft fälschlicherweise ein hohes Rückfallrisiko zugeschrieben bekamen wie weiße Angeklagte. Umgekehrt wurden Weiße Angeklagte häufiger fälschlicherweise in ein geringes Rückfallrisiko eingestuft. Hinzu kommt, wie sich bei der Untersuchung von über 10.000 Straftäter*innen in Broward County (Florida) herausstellte, dass COMPAS das Rückfallrisiko bei allgemeinen Straftaten in 65% der Fälle korrekt vorhersagte, bei gewalttätigem Rückfall jedoch nur in 20% der Fälle.

Der Algorithmus von COMPAS kann sehr große Datenmengen in hoher Geschwindigkeit prozessieren und auf der Basis der zugrunde liegenden Daten eindeutige Entscheidungen vorlegen. Es gibt jedoch Bedenken hinsichtlich der Vergleichsdaten, mit denen der Algorithmus trainiert wurde, denn möglicherweise sind diese von rassistischen Diskriminierungen und Vorurteilen von Menschen beeinflusst. Dies könnte Diskriminierung und Vorurteile verstärken und soziale Ungleichheiten weiter zementieren, da die vermeintliche Neutralität des Algorithmus den Entscheidungen eine scheinbare Legitimität verleiht. Besonders deutlich wird die Problematik, bei der Analyse und Gegenüberstellung realer Fälle. Ein Bericht von ProPublica stellt mehrerer solcher Fälle vor. In einem Fall wurden zwei Freundinnen, darunter die 18-jährige Brisha Borden, wegen Diebstahls von Kinderspielzeug im Wert von 80 $ festgenommen. Sie hatte bis zu diesem Zeitpunkt kleinere Vergehen in ihrer Jugendzeit begangen. Im Vergleich dazu wurde Vernon Prater, ein 41-jähriger Mann mit einer kriminellen Vergangenheit mit bewaffneten Überfällen, wegen Diebstahls von Werkzeugen im Wert von 86,35 $ festgenommen. COMPAS bewertete Borden, eine Schwarze Frau, mit einem hohen Risikowert von 8, während Prater, ein Weißer Mann, einen niedrigen Risikowert von 3 erhielt. Nach zwei Jahren hatte Borden keine weiteren Verbrechen begangen, während Prater wegen Einbruchs und Diebstahls zu einer achtjährigen Haftstrafe verurteilt wurde. In einem weiteren Fall wurden zwei Männer – Dylan Fugett und Bernard Parker – unabhängig voneinander wegen Drogenbesitzes verhaftet und mit dem COMPAS-System bewertet. Dylan Fugett, ein Weißer Mann mit einer vorherigen Straftat wegen versuchten Einbruchs, wurde als niedriges Risiko mit einer Bewertung von 3 eingestuft. Trotz dieser niedrigen Bewertung wurde Fugett nach der COMPAS-Bewertung noch dreimal wegen Drogenbesitzes verhaftet. Im Gegensatz dazu wurde Bernard Parker, ein Schwarzer Mann mit einer vorherigen Straftat wegen Widerstands gegen eine Verhaftung (ohne Gewalt), als hohes Risiko mit einer Bewertung von 10 eingestuft. Interessanterweise hat Parker nach dieser Bewertung keine weiteren Straftaten begangen. In einer Studie von Forscher*innen der Dartmouth Universität wurde zudem festgestellt, dass COMPAS nicht besser darin ist die Rückfallwahrscheinlichkeiten von Straftäter*innen vorherzusagen als eine Online-Umfrage mit Menschen ohne relevante Erfahrung auf diesem Gebiet. Die Forscher*innen baten hierfür 400 Teilnehmer*innen, basierend auf minimalen Informationen (Alter, Geschlecht, Tatvorwurf, Schweregrad der Straftat und frühere Verurteilungen vor Gerichten) über 50 Straftäter*innen, die Wahrscheinlichkeit eines erneuten Straftatverhaltens vorherzusagen.

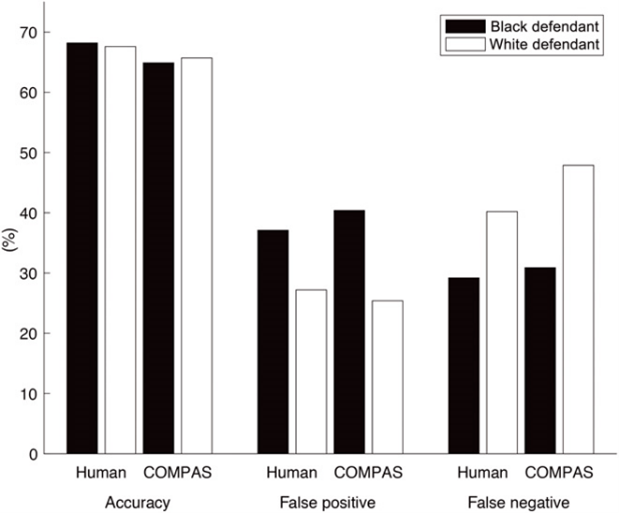

Die Ergebnisse zeigten, dass die Vorhersagen der Menschen mit einer Genauigkeit von 67% nahezu genauso genau waren wie die von COMPAS mit 65%. Sowie bei COMPAS bekamen die Teilnehmer*innen der Umfrage keine direkte Information über die Hautfarbe der Angeklagten. Doch auch bei der Umfrage zeigte sich – wie bei den Ergebnissen von COMPAS – dass Schwarze Menschen häufiger als potenzielle Wiederholungs-täter*innen eingestuft wurden als weiße Menschen (Ausführlicher im Balkendiagramm aus dem Paper von Julia Dressel und Hany Farid zu sehen).

Die Problematik besteht darin, dass obwohl die Hautfarbe/Ethnie der Täter*innen nicht explizit für die Wahrscheinlichkeitsberechnung verwendet wird – was auch zutiefst unethisch wäre – Hautfarbe/Ethnie weiterhin nahezu alle Lebensbereiche beeinflussen. Dies umfasst, unter anderen, Aspekte wie Armut, Arbeitslosigkeit, Wohnort, geringere Bildungschancen oder auch geringeres Einkommen – wovon Schwarze Menschen (besonders in den USA) höher betroffen sind als weiße Menschen. Diese Faktoren werden wiederum als Datenpunkte in die Bewertung mit einbezogen, demnach fließt die Hautfarbe/Ethnie und die damit zusammenhängende Diskriminierung wieder indirekt in die Bewertung mit ein. Die Ergebnisse zu denen sowohl der Algorithmus als auch die menschlichen Entscheidungsträger*innen kommen, verdeutlichen somit die tief verankerte soziale Ungleichheit und die rassistischen Strukturen in unserem Alltag.

Algorithmen können also mit den Daten, die wir ihnen zur Verfügung stellen, lediglich unsere Gesellschaft widerspiegeln und reflektieren somit sowohl ihre Vielfältigkeit als auch ihre verankerten Probleme und Ungleichheiten. Es ist demnach von entscheidender Bedeutung, einen bewussten und reflektierten Umgang mit Algorithmen und den zugrundeliegenden Daten zu pflegen. Die Funktionsweise dieser Algorithmen bleibt oft undurchsichtig, und diejenigen, die sie programmieren, verfügen nicht immer über die erforderliche rechtliche und ethische Ausbildung, um gerechte Entscheidungsfindungen zu gewährleisten. Der unreflektierte Einsatz von – Rassismus verzerrten – Daten, kann somit dazu führen, dass soziale Ungleichheiten hinter der vermeintlichen Neutralität des Algorithmus verborgen bleiben. Es ist daher von entscheidender Bedeutung, die Implementierung und Anwendung von Algorithmen kontinuierlich zu hinterfragen, zu evaluieren und zu optimieren, um eine gerechtere und inklusivere Gesellschaft zu fördern und soziale Ungleichheiten nicht zu reproduzieren.